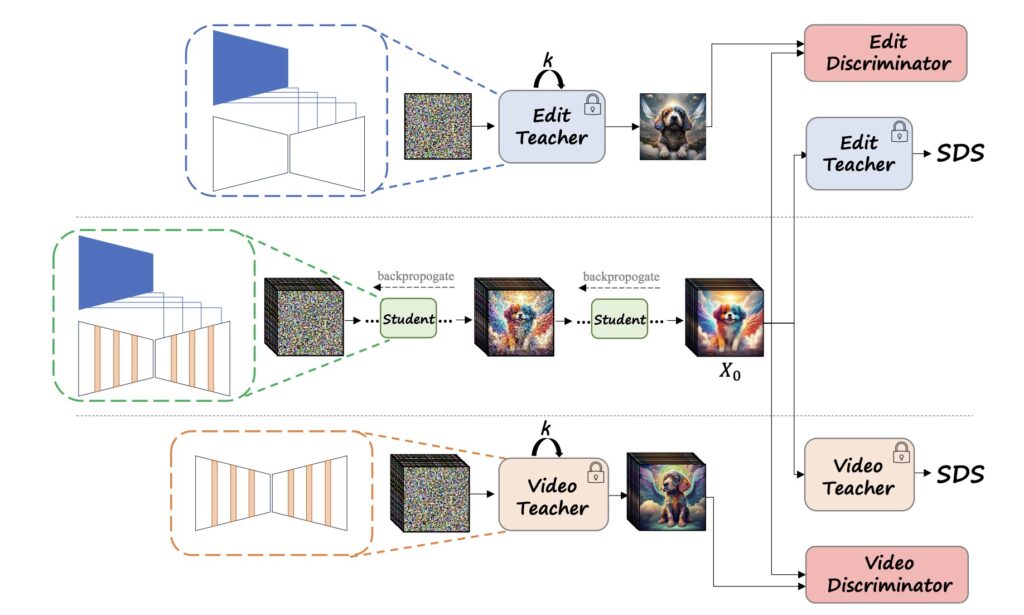

EVE(Emu Video Edit)是Meta AI开发的一个视频编辑模型

EVE模型通过结合先进的图像处理技术、无监督学习方法和文本理解能力,实现了一种全新的视频编辑方式。这种方法不仅提高了视频编辑的质量和效率,也使得复杂的视频编辑任务变得更加易于操作和可访问。

- 精确的帧编辑:利用图像编辑适配器,EVE能够对视频中的每一帧进行精确的编辑。这包括更改帧的内容、调整颜色、添加或删除对象等,从而实现详细且具体的编辑需求。

- 保持时间连贯性:通过视频生成适配器,EVE确保编辑后的帧之间保持时间上的连贯性。这意味着视频的每一帧都与前后帧自然过渡,无论进行了何种编辑,都不会破坏视频流的连贯性。

-

无监督学习:EVE通过分解扩散蒸馏的无监督学习过程,能够从没有标记的数据中学习视频编辑的技巧。这让EVE能够在没有大量标记数据的情况下,还能持续提高其视频编辑的能力。

-

多样化编辑功能:EVE支持广泛的视频编辑功能,如背景更换、风格转换、对象的添加与删除等。这些功能使得EVE能够应对各种视频编辑场景,提供高度定制化的视频编辑解决方案。

-

文本到视频的编辑命令:EVE能够理解并执行基于文本的编辑命令,这意味着用户可以通过简单的文本描述来指导视频的编辑过程。这大大简化了视频编辑的复杂度,使得非专业用户也能轻松进行复杂的视频编辑任务。

技术原理:

-

图像编辑适配器与视频生成适配器:

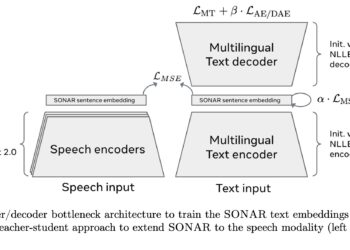

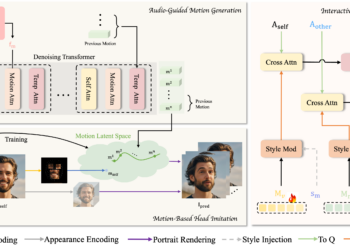

- EVE模型包括两个主要的组件:图像编辑适配器和视频生成适配器。图像编辑适配器专注于对单帧图像进行编辑操作,如改变颜色、添加或删除物体等。视频生成适配器则确保编辑过程中帧与帧之间保持时间上的连贯性,使视频流畅自然。

- 这两个适配器被设计为可以附加到现有的文本到图像模型上,这样EVE就能理解和执行基于文本的编辑命令,使得编辑过程更加直观和灵活。

-

分解扩散蒸馏(Factorized Diffusion Distillation):分解扩�