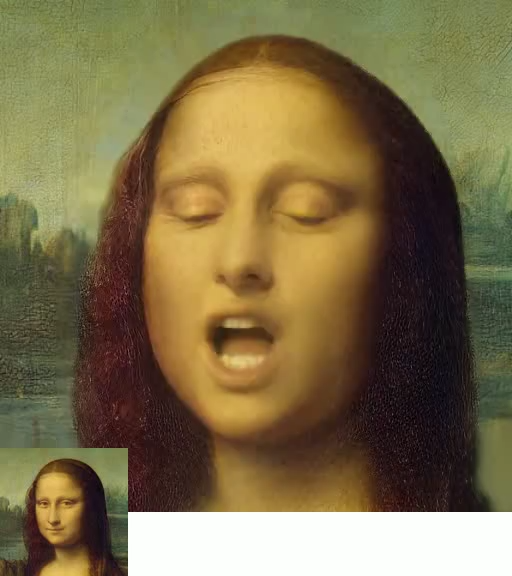

VASA-1,由微软亚洲研究员开发的项目,可以实现从单一静态图像和一段语音音频生成逼真的对话面部动画。VASA-1 不仅能够精确同步音频和唇部动作,还能捕捉到丰富的面部细微表情和自然的头部动作,增强了真实感和生动感。

支持1分钟的音频输入

主要功能:

- 逼真的面部动画: VASA-1 能够根据单一静态图像和一段语音音频,生成逼真的对话面部视频。这包括唇部运动与音频的精确同步,以及复杂的面部表情和头部动作。

- 高度自然的头部动作: 除了面部表情,VASA-1 还能生成自然的头部运动,如点头和转头,这些都是人类交流中常见的非语言行为。

- 实时视频生成: 利用 NVIDIA RTX 4090 GPU,实现了高性能的视频生成,支持离线模式下的 512×512 分辨率视频以 45fps 生成,以及在线流模式下的 40fps 生成速度,前置延迟仅 170 毫秒。这种高效的视频处理能力使其非常适合实时应用,如虚拟现实、增强现实和视频游戏,同时也适用于需要高帧率和低延迟的专业视频内容制作和直播。

- 泛化能力:模型即使面对与训练时不同的音频或图像(比如不同的语言或非常规的艺术照片),也能够有效工作,这显示了它强大的适应能力。

名画人物

名画人物动画人物

支持中文等多种语言

还可以唱歌

- 解耦能力:模型能够将人脸的不同动态特征(如嘴唇运动、表情、眼睛注视方向等)独立处理和控制的能力。在VASA-1模型中,通过建立一个包含全面面部动态和头部动作的潜在空间,实现了高度的解耦。这一潜在空间允许模型单独操控生成过程中的各个面部特征,从而在应用中可以根据需要对特定的动态进行精细调整,如单独改变头部姿势而不影响面部表情。这种解耦设计不仅增强了模型的可控性,也提高了生成内容的自然性和多样性。

姿势和表情编辑(原始生成结果、只生成姿势的结果、只生成表情的结果以及带有旋转姿势的表情)

姿势和表情编辑(原始生成结果、只生成姿势的结果、只生成表情的结果以及带有旋转姿势的表情) -

生成的可控性:通过引入可选的条件信号,如主要的眼睛注视方向、头部距离和情绪偏移,大大增强了视频生成的可控性。以下是这些信号如何有助于产生更受控制和更具动态性的视频输出:

-

眼睛注视方向:

- 此信号允许模型控制生成的人物头像的注视方向,使得视频中的虚拟角色可以模拟出注视特定对象或某个方向的自然行为,增强了人物表现的真实性和互动性。

-

头部距离:

- 通过调整头部与摄像机的距离,可以改变视频中人物的视觉比例和观感。这不仅可以应用于个性化用户体验,还可以根据具体的场景需求调整人物在画面中的呈现方式。

-

情绪偏移:

- 情绪偏移信号允许在生成过程中加入特定的情绪表达,如快乐、悲伤或愤怒等,从而使得生成的视频能够更好地传达特定的情绪和氛围,适用于需要情感交互的应用场景,如互动教学、广告或虚拟客服等。

不同头部与摄像机距离标度下的生成结果

不同情绪偏移(分别为中性、快乐、愤怒和惊讶)下的生成结果

不同主要注视方向(分别为前向、左向、右向和上向)下的生成结果

- 情绪偏移信号允许在生成过程中加入特定的情绪表达,如快乐、悲伤或愤怒等,从而使得生成的视频能够更好地传达特定的情绪和氛围,适用于需要情感交互的应用场景,如互动教学、广告或虚拟客服等。

-

技术原理

VASA-1 项目利用了一系列先进的计算机视觉和机器学习技术,实现了高度逼真的音频驱动的对话面部动画。下面详细介绍其核心技术原理:

1. 面部潜在空间构建

VASA-1 通过构建一个面部潜在空间来生成动态的面部表情和头部动作。这一空间是通过分析和处理大量面部视频数据建立的,目的是在保持高度表现力的同时实现面部动态和其他因素(如身份和外观)之间的解耦。

- 数据集处理:使用大量的面部视频数据,通过自监督或弱监督的方式训练模型,确保面部表情和头部动作的自然和逼真。

- 3D 辅助表征:引入3D模型来帮助表征和生成面部动态,这包括3D头部姿势和面部表情的合成,增加了生成动画的真实感和准确性。

2. 整体面部动态和头部动作生成

使用基于扩散的模型(Diffusion Model)和变换器(Transformer)结构,在潜在空间中生成整体的面部动态和头部动作。

- 扩散模型:这是一种生成模型,通过逐步增加噪声并再逐步去除噪声来生成数据,非常适合处理复杂的数据分布,如人脸动画。

- Transformer架构:利用Transformer的强大能力来处理序列数据,使得生成的面部动画不仅与原始音频同步,而且能够捕捉到微妙的面部表情变化。

3. 音频条件化的生成控制

VASA-1 模型能够接受音频输入,并根据该音频生成对应的面部动画和头部动作,实现高度同步和自然表达。

- 音频特征提取:使用先进的音频处理技术(如 Wav2Vec)提取音频特征,这些特征随后被用作生成模型的条件输入。

- 可控生成:除了音频,模型还可以接受其他控制信号(如眼睛注视方向、头部与相机的距离、情感偏移等),以进一步细化和个性化生成的动画。

4. 实时生成支持

VASA-1 支持高效的实时生成,能够在几乎没有启动延迟的情况下,生成高分辨率的视频流。

- 优化算法:通过算法优化确保模型在保持高质量输出的同时,运行速度快,满足实时应用的需求。

- 硬件加速:利用现代计算硬件(如 GPU 加速)来提高处理速度,支持更复杂的模型和更高的帧率。

一些案例:

(注:本页面上的所有肖像图像都是由 StyleGAN2 或 DALL-E-3 生成的虚拟、不存在的身份(蒙娜丽莎除外)。

项目及演示:https://www.microsoft.com/en-us/research/project/vasa-1/