Character.AI发布了一篇文章介绍了Character.AI在优化大语言模型(LLM)推理效率方面所做的技术创新和改进,并分享他们在实现高效、经济和可扩展的AI服务方面取得的成就。

- Character.AI目前每秒处理超过20,000次推理查询。

- 通过这些技术创新,服务成本相比2022年底减少了33倍。

- 技术改进:

- 多查询注意力:他们找到了一种方法来减少AI系统在记忆和处理信息时需要的空间,这样可以加快速度。

- 混合注意力:他们把两种不同的注意力方式结合起来使用,一种是只关注一部分信息,另一种是关注所有信息。这样既能保证速度又能保证准确性。

- 跨层共享:他们让不同部分的AI系统共享信息,进一步减少需要的空间和时间。

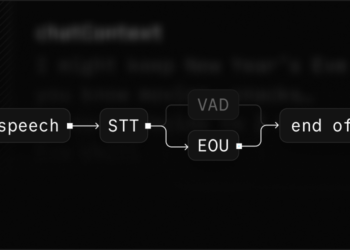

- 缓存系统:

- 他们开发了一个更高效的缓存系统,可以在对话的不同回合之间保存和快速检索信息。这就像我们在聊天时,记住了之前说过的话,可以更快地接着聊下去。

- 量化技术:

- 他们使用了一种叫“量化”的技术,把AI系统中的数据压缩,使得训练和运行AI系统的过程更快、更省钱。

以下是文章详细翻译