StoryDiffusion 是一个基于一致性自注意力(Consistent Self-Attention)和语义运动预测(Semantic Motion Predictor)技术的创新生成模型。它主要用于生成一系列风格和内容一致的图像和视频,适用于需要连续视觉内容来讲述故事的场景。

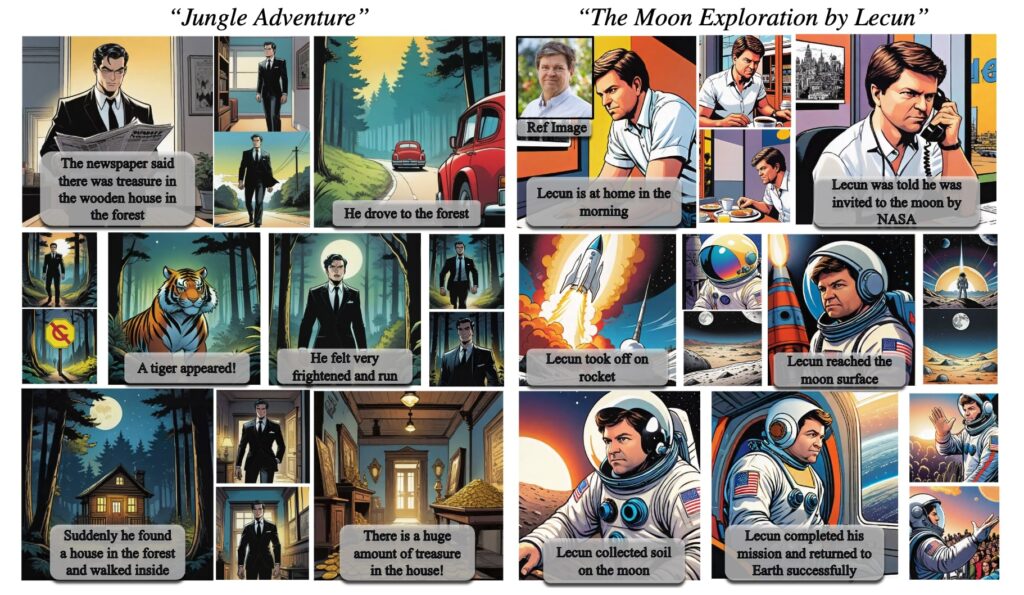

比如创建一个短片来讲述一个探险故事。通过StoryDiffusion,你可以输入一系列描述探险活动的文本(例如“探险者在丛林中行走”,“发现隐藏的宝藏”),模型会根据这些文本提示生成一系列内容连贯、风格一致的图像和视频。这些图像和视频不仅在视觉上吸引人,而且因为保持了高度一致性,观众能够更流畅地理解和跟随故事的进展。

例如:通过提出的一致性自注意力,StoryDiffusion 以各种风格创作漫画,保持一致的角色风格和服饰,实现连贯的叙事。

可以创作风格一致的漫画

StoryDiffusion 解决了以下几个关键问题:

-

图像和视频内容的一致性:

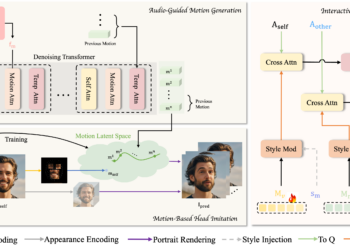

- 在生成一系列图像或视频时,保持角色的身份和服装风格的连贯性是一个挑战。StoryDiffusion 通过一致性自注意力技术有效地解决了这一问题,确保了在连续的图像和视频中角色的风格和属性保持不变。

-

长距离视频生成的平滑性:

- 传统的视频生成技术在生成长视频时往往会遇到画面跳跃或内容不连贯的问题。StoryDiffusion 引入的语义运动预测器能够在语义空间中预测和控制图像之间的运动,生成平滑且连贯的长距离视频。

-

生成内容的高度可控性:

- 在许多生成模型中,尤其是基于文本的生成模型,很难同时保持高度的可控性和内容的一致性。StoryDiffusion 允许用户通过文本直接控制生成内容,大大增强了模型对生成过程的控制能力。

-

计算资源的高效利用:

- 对于复杂的生成任务,尤其是视频内容的生成,通常需要大量的计算资源。StoryDiffusion 提供了一种轻量级的方法,通过一致性自注意力和语义运动预测器减少了对计算资源的需求,使得在现有硬件上运行更加高效。

-

跨图像内容生成的扩展性:

- 在生成多图像内容时,如何有效地扩展单图像生成模型到多图像或视频生成是一个技术挑战。StoryDiffusion 的方法可以无缝地应用于多图像生成,扩展了模型的应用范围和效果。

主要功能特点

-

一致性图像生成:

- 利用一致性自注意力(Consistent Self-Attention)技术,StoryDiffusion 能够在生成序列图像时保持角色的身份和服装风格的一致性。这对于需要连续图像来讲述故事的应用场景尤为重要,如数字漫画和故事叙述。

-

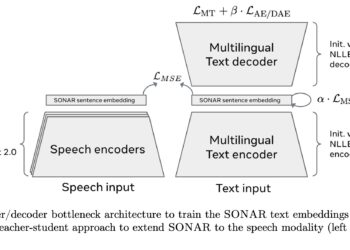

一致性自注意力是StoryDiffusion 中的一项核心技术,它是对传统自注意力机制的一种改进。在生成模型中,自注意力机制通常用于模型内部不同部分之间的信息交互,有助于捕捉和利用长距离的依赖关系。