Fish Audio 发布高级语音处理模型Fish Agent V0.1 3B,它是一个语音到语音模型,它可以高效、精确地生成和处理语音,尤其适合模拟或克隆不同的声音。

该模型是在 Qwen-2.5-3B-Instruct 的基础上继续预训练完成的,涵盖了 2000 亿语音和文本令牌。

- 端到端架构:采用无语义层的真正端到端(E2E)架构。

- 零样本语音克隆:支持无需训练即可实现语音克隆。

- 精简的 3B 参数:使用 30 亿参数,便于开发。

- 支持文本和音频输入:灵活的多输入方式。

- 超快响应时间:仅需 200 毫秒的文本到音频转换时间(TTFA)。

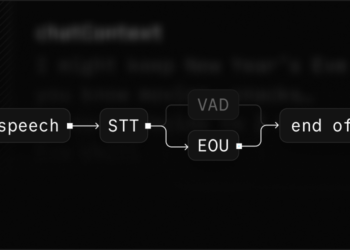

Fish Agent V0.1 3B 的一大特点是无语义令牌架构。这意味着它不像传统模型那样需要先把语音转换成复杂的语义编码(如 Whisper 和 CosyVoice 使用的编码),而是直接在声音层面上处理和生成语音。这种直接处理方式让模型的反应速度更快,结构更简单,效率也更高。

Fish Agent V0.1 3B 可以快速、自然地生成高质量语音,同时减少了传统模型的复杂步骤,从而实现“即时”语音克隆和文本到语音转换。这让它更适合需要实时语音生成的应用,比如语音助手、自动客服、以及各种需要快速语音反馈的场景。

支持的语言及数据规模

- 英语 (en): 约 30 万小时

- 中文 (zh): 约 30 万小时

- 德语 (de), 日语 (ja), 法语 (fr), 西班牙语 (es), 韩语 (ko), 阿拉伯语 (ar): 各约 2 万小时

关键特性

- 语音到语音生成:该模型能够捕捉并生成自然环境音频,适用于高精度语音生成任务,提供更真实的音频表现。

- 文本到语音转换:Fish Agent V0.1 3B 也是一款先进的 TTS 模型,支持将文本内容转换为高质量的语音输出。

- 多语言支持:该模型支持英语、中文、德语、日语、法语、西班牙语、韩语和阿拉伯语等多种语言,具备广泛的应用潜力。

- 大规模训练数据:模型基于约 70 万小时的多语言音频数据训练,使其在处理多种语言和语境时具备出色的适应性。

- 创新架构:Fish Agent V0.1 3B 采用了无语义令牌的架构,不需要传统的语义编码/解码器。这种设计提升了处理效率,同时可以减少对额外模块的依赖,使生成效果更稳定和高效。

同时Fish Audio 发布了Fish Speech 1.4 技术报告。

Fish-Speech 提出了一个具有多语言和多情感稳定性的创新 TTS 解决方案,通过快-慢双重自回归架构结合非字母-音素(non-G2P)架构,实现了跨语言和情感多样的高质量语音合成。

GitHub: http://github.com/fishaudio/fish-speech

Fish Agent Demo: http://huggingface.co/spaces/fishaudio/fish-agent

模型下载: http://huggingface.co/fishaudio/fish-agent-v0.1-3b

技术报告: http://arxiv.org/abs/2411.01156

目前,Fish Agent 的初步演示版本可以在 fish.audio/demo/live 上体验。