LVCD 是一个专门为动画视频线稿上色设计的工具。它通过一种新的方法,把黑白线稿自动转化为彩色动画视频。

传统的方法是逐帧为每一张图片上色,效率低且容易造成视频前后不一致。而 LVCD 利用了一种先进的扩散模型,可以同时处理整个视频序列,保证每一帧的颜色连贯,尤其是在角色快速移动时,也能保持颜色一致。

主要功能

- 线稿视频上色:LVCD能够自动为黑白线稿动画帧进行上色。通过使用参考帧的颜色信息,系统可以生成具有时间一致性的彩色动画视频,适用于长时间序列的动画制作,并有效保证多帧动画的颜色连贯性。

- 大幅动作处理:LVCD特别擅长处理大幅度运动的动画场景。通过扩散模型和参考注意力机制,即使在快速或大幅运动的情况下,动画中的角色和背景颜色也能保持一致,避免颜色错位或失真。

- 长视频生成:LVCD支持生成长时间的视频,不受原始模型固定长度的限制。通过分段采样机制和重叠混合模块,系统能够生成超过原有模型限制的长序列动画,并在多个视频段之间保持色彩和内容的一致性。

- 时间一致性保证:LVCD的核心功能是保持帧与帧之间的时间一致性。通过使用“Overlapped Blending Module”和“Prev-Reference Attention”,它确保了长序列动画中各帧之间的颜色和内容一致性,避免了色彩跳变或帧间不协调的情况。

- 参考帧颜色迁移:LVCD可以利用参考帧中的颜色信息,将这些颜色准确迁移到其他帧中。即使其他帧与参考帧有较大的内容或运动幅度差异,系统也能保证颜色的一致性,生成连贯的视觉效果。

- 支持多样化的线稿输入:LVCD能够处理多种类型的线稿输入,包括手绘线稿和自动生成的线稿。无论线稿风格如何,该系统都可以进行精准的上色处理,展现出强大的适应能力。

技术方法

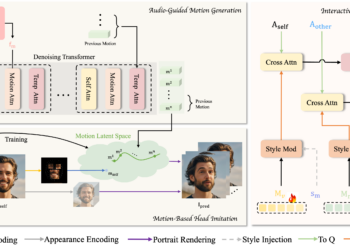

- 模型结构:LVCD基于Stable Video Diffusion (SVD)模型构建,引入了Sketch-guided ControlNet和Reference Attention来处理复杂的动画场景。该模型通过噪声生成的潜在空间,逐步生成时间一致的高质量动画帧。

- 时间一致性采样:通过引入Overlapped Blending和Prev-Reference Attention机制,LVCD能够跨多个段落生成长时间一致的视频,减少生成过程中的累积误差。

1. Stable Video Diffusion (SVD) 模型基础

1. Stable Video Diffusion (SVD) 模型基础

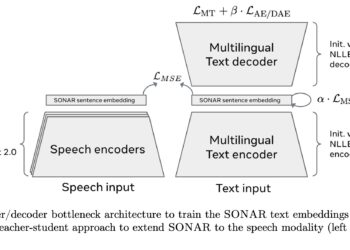

SVD 是作者用于视频生成的基础模型,它基于扩散模型进行视频生成,主要分为两个部分:

- VAE 编码器和解码器:用于将输入视频帧映射到低维潜在空间,并将潜在变量解码回视频帧。

- U-Net 网络:经过微调,用于对这些潜在变量进行去噪操作,通过引入时间层(如 3D 卷积和时间注意力层)来生成时序一致的视频。

2. 草图引导的ControlNet(Sketch-guided ControlNet)

Sketch-guided ControlNet 是 LVCD 的另一大核心技术,它允许用户通过输入线稿,控制生成的视频内容。ControlNet 是一种基于神经网络的扩展结构,专门用于处理输入的结构化数据,如线稿。在 LVCD 中,ControlNet 通过将输入的线稿与预训练的扩散模型结合起来,确保生成的视频与线稿的布局和形状严格对应。

- ControlNet的作用是通过引入线稿作为额外条件进行控制,确保模型生成的视频与线稿的结构和布局相符。作者复制并修改了U-Net的编码器,并增加了零初始化的卷积层,用来对线稿进行编码,并将线稿特征与U-Net的输入连接,最终引导生成与线稿一致的彩色动画。其工作机制如下:

- LVCD 在输入的线稿上进行编码,提取其中的结构信息,并将这些信息传递给生成模型。

- 然后,生成模型依据这些信息生成符合线稿结构的彩色动画。

通过引导生成过程,ControlNet 确保了生成的视频不仅颜色准确,还能在大幅动作的场景中保持画面的连贯性和准确性。

3. 参考注意力机制(Reference Attention)

在处理长序列视频时,参考注意力机制是 LVCD 保证色彩一致性和跨帧连贯性的重要技术之一。该机制的作用是从输入的参考帧中提取颜色和其他视�