高考覆盖各类学科及题型,同时因其开考前的“绝密性”,被视作中国最具权威的考试之一,成为评估考生综合能力的“试金石”。这一面向人类设计的高难度综合性测试,目前普遍被研究者用于考察大模型的智能水平。

上海人工智能实验室使用其司南评测体系OpenCompass,选取6个开源模型及GPT-4o,进行高考“语数外”全卷能力测试。

评测采用全国新课标I卷,参与评测的所有开源模型,开源时间均早于高考,确保评测 “闭卷”性。同时,成绩由具有高考评卷经验的教师人工评判,更加接近真实阅卷标准。

参与本次“大模型高考”的模型:

-

Mixtral 8x22B:法国AI创业公司Mistral于2024年4月17日开源的对话模型。 -

Yi-1.5-34B:零一万物公司于2024年5月12日开源的Yi-1.5系列最大的模型。 -

GLM-4-9B:智谱AI于2024年6月4日推出的最新一代预训练模型GLM-4系列的开源版本。 -

InternLM2-20B-WQX:上海人工智能实验室于2024年6月4日开源的书生·浦语2.0系列文曲星大语言模型。 -

Qwen2-57B:阿里巴巴于2024年6月6日开源的Qwen2系列MoE对话模型。 -

Qwen2-72B:阿里巴巴于2024年6月6日开源的72B稠密模型。

因无法确定闭源模型的更新时间,为公平起见,此次评测没有纳入商用闭源模型,仅引入GPT-4o作为评测参考。

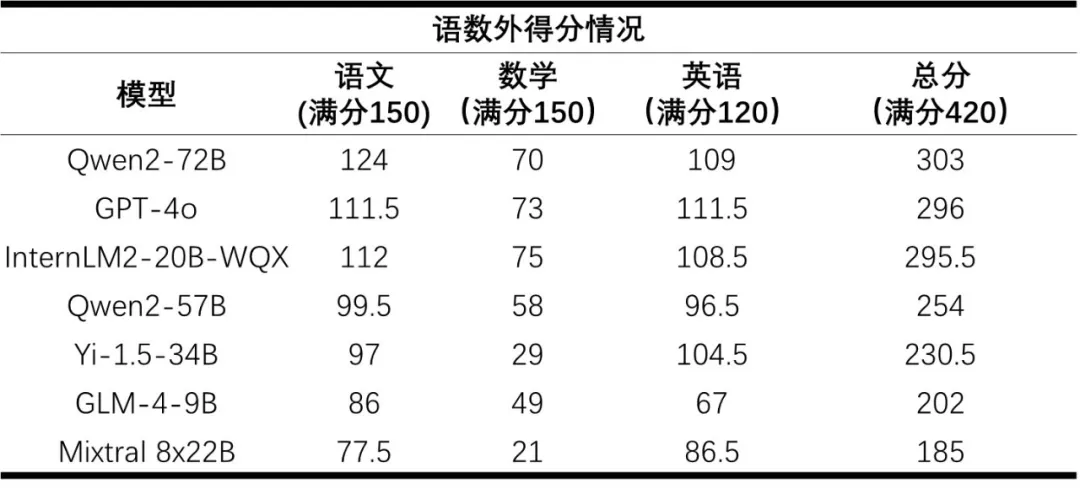

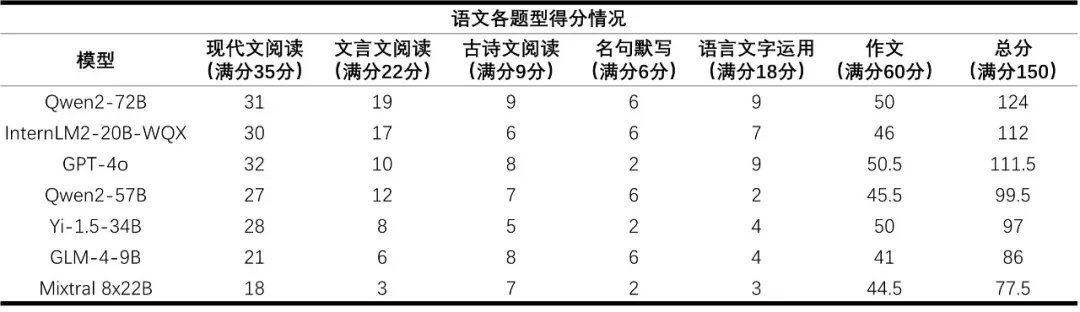

上述模型的高考“语数外”三科成绩结果如下表所示:

评测采用“语数外”三科题目作为测试集,仅输入文字题干(数学包含2道带图试题),不纳入英语听力部分(30分)。

总分前三名Qwen2-72B、GPT-4o、InternLM2-20B-WQX对应得分率分别为72.1%、70.5%和70.4%。

大部分模型在“语言”本质上的表现良好,语文平均得分率为67%,英语更是达到了81%。

而数学则是所有大模型的短板,平均得分率仅为36%。得益于研究团队在数学推理上的投入,InternLM2-20B-WQX取得了75分的最高分,超过所有受测模型。然而仍未达到及格水平,这表明大模型的数学能力存在较大提升空间。

阅卷教师对大模型“考生”的评价

本次阅卷采用与高考一致的完全匿名形式,所有大模型答卷均进行了匿名处理,避免阅卷教师产生“先入为主”的观念。

在阅卷开始前,阅卷教师未被告知答卷均由模型生成,使阅卷教师完全以面对真实考生的标准评判回答效果。完成所有大模型答卷的评卷工作后,阅卷教师被告知所评“考生”的真实身份为大模型。

研究人员同时邀请各科教师对大模型表现进行了整体分析,为模型能力提升策略提供参考。

语文:模型的现代文阅读理解能力普遍较强,但是不同模型的文言文阅读理解能力差距较大。大模型作文更像问答题,虽然有针对性但缺乏修饰,几乎不存在人类考生都会使用举例论证、引用论证、名人名言和人物素材等手法 。

多数模型无法理解“本体”“喻体”“暗喻”等语文概念。语言中的一些“潜台词”,大模型尚无法完全理解。

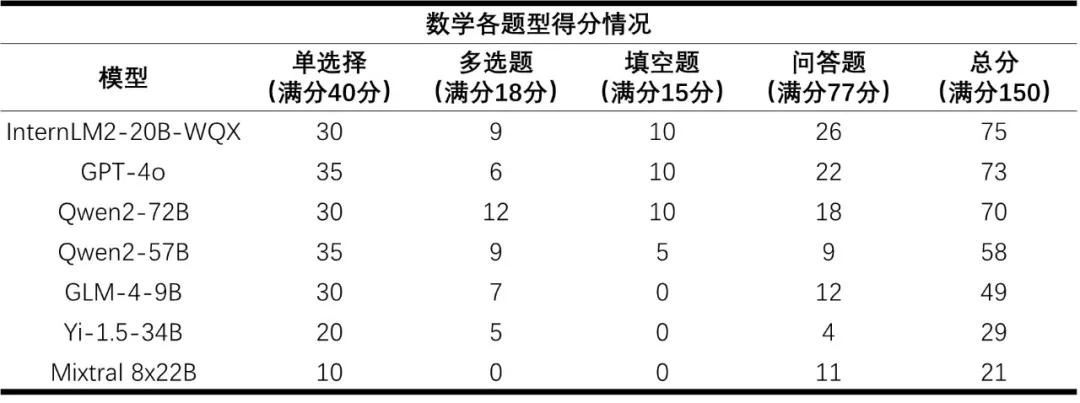

数学:

大模型的主观题回答相对凌乱,且过程具有迷惑性,甚至出现过程错误但得到正确答案的情况。

大模型的公式记忆能力较强,但是无法在解题过程中灵活引用。

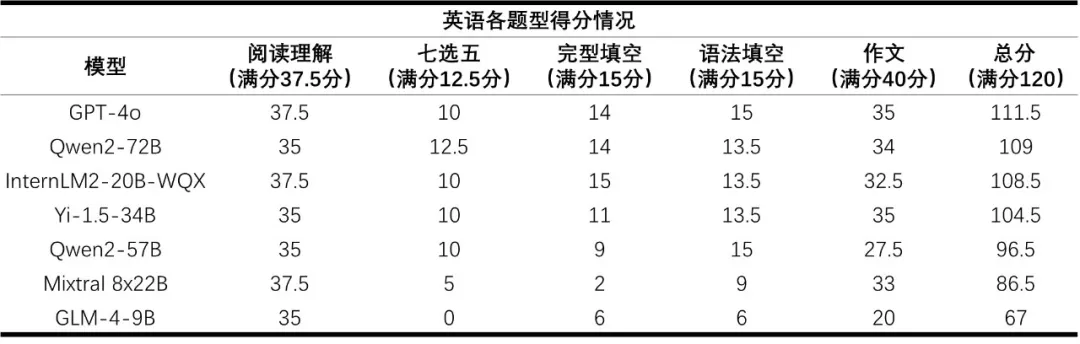

英语:

英语整体表现良好,但部分模型由于不适应题型,在七选五、完形填空等题型得分率较低。

大模型英语作文普遍存在因超出字数限制而扣分的情况,而人类考生多因为字数不够扣分。

GAOKAO-Eval 高考评估模型