苹果于周一发布了Apple Intelligence的开发者预览版本,但仅供部分设备使用。这些设备包括iPhone 15 Pro和iPhone 15 Pro Max,以及配备M1芯片或更高版本的Mac和iPad。

尽管今天的 Beta 版带来了 Apple Intelligence,但部分功能(例如更高级的 Siri)目前还无法使用。

而且此次更新不的Apple Intelligence不支持欧洲和中国用户的设备。

同时苹果还发布了一份技术报告,详细介绍了苹果智能系统(Apple Intelligence)的详细信息。根据报告内容,其AI系统Apple Intelligence的基础模型是在Google设计的定制Tensor处理单元(TPU)上进行预训练的。

同时苹果还发布了一份技术报告,详细介绍了苹果智能系统(Apple Intelligence)的详细信息。根据报告内容,其AI系统Apple Intelligence的基础模型是在Google设计的定制Tensor处理单元(TPU)上进行预训练的。

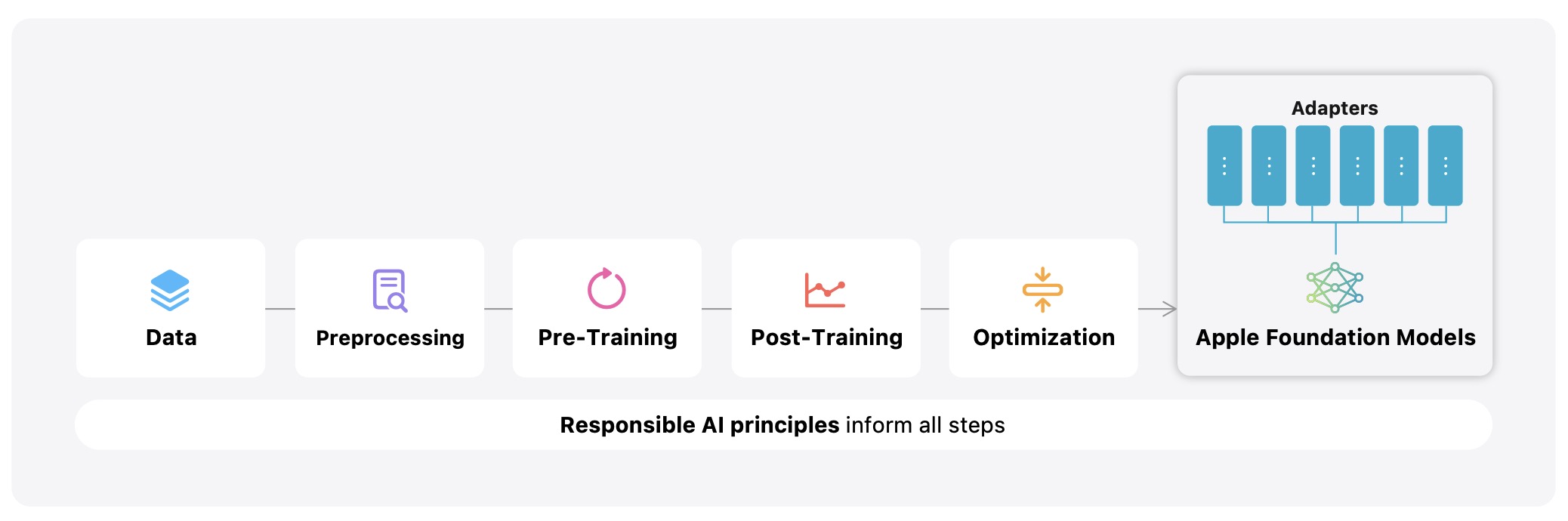

苹果并未在技术报告中提及Google或Nvidia的名字,但指出其Apple Foundation Model(AFM)和AFM服务器是在“云TPU集群”上训练的,这意味着苹果租用了云服务提供商的服务器进行计算。

以下是该技术报告的具体内容:

苹果智能系统及核心模型

苹果智能系统

苹果智能系统(Apple Intelligence)是苹果公司在2024年全球开发者大会(WWDC 2024)上发布的个人智能系统。该系统深度集成在iOS 18、iPadOS 18和macOS Sequoia中,旨在通过多种强大的生成模型,为用户日常任务提供快速、有效的支持。以下是苹果智能系统的一些关键特性:

- 多任务处理: 苹果智能系统能够处理多个任务,如文本生成、通知优先级和总结、创建会话图像等。

- 动态适应: 这些模型可以根据用户当前的活动实时进行调整,以提供个性化的智能体验。

- 深度集成: 系统与苹果设备的操作系统深度集成,确保智能功能的无缝运行。

核心模型

核心模型

苹果智能系统的核心模型包括两种主要类型: