6月2日,英伟达联合创始人兼首席执行官黄仁勋在Computex 2024(2024台北国际电脑展)上发表主题演讲,分享了人工智能时代如何助推全球新产业革命。

演讲要点总结

- 新品发布与摩尔定律的突破

- 展示了最新量产版Blackwell芯片,2025年推出Blackwell Ultra AI芯片,下一代AI平台命名为Rubin,2027年推Rubin Ultra。

- 更新节奏为“一年一次”,打破摩尔定律。

- AI技术与大语言模型

- 英伟达推动大语言模型诞生,自2012年后改变了GPU架构,将新技术集成在单台计算机上。

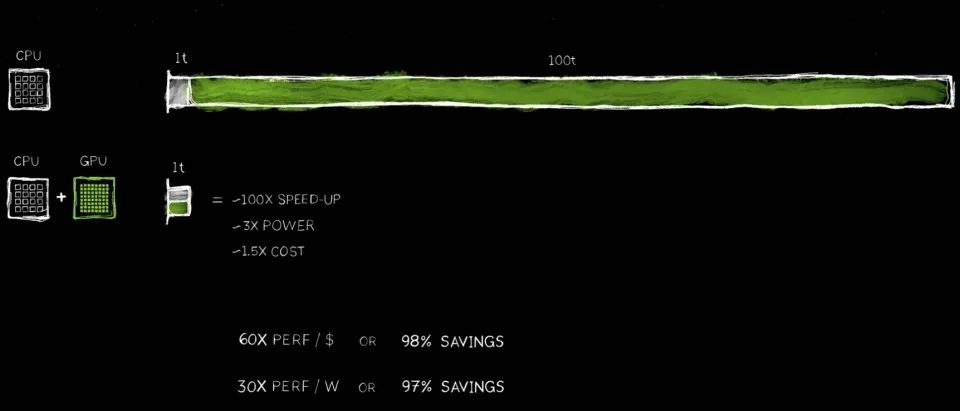

- 加速计算技术实现100倍速率提升,功耗仅增加到原来的3倍,成本为原来的1.5倍。

- AI与物理世界的结合

- 未来AI需要理解物理世界,通过视频与合成数据学习,并让AI互相学习。

- 提出token的中文译名——词元。

- 机器人时代

- 机器人时代已经到来,所有移动的物体都将实现自主运行。

- 加速计算的经济效益

- 加速计算带来100倍的性能提升,功率仅增加3倍,成本上升1.5倍,显著节省费用。

- 推出了350个加速库,覆盖医疗、金融、计算机、汽车等多个行业。

- 生成式人工智能

- 生成式人工智能带来深远影响,将成为新的计算平台,替代传统的软件制造业。

- 介绍了Nim(NVIDIA Inference Microservices),一个集成化的人工智能容器解决方案。

- 地球2号项目

- 创建地球的数字孪生体,模拟地球的运行,以预测未来变化,预防灾难,理解气候变化。

- AI超算的崛起

- 自2012年起,通过与科学家的合作,推动深度学习的发展,实现了人工智能超级计算机的突破。

- 数字人与AI PC

- 数字人技术的进展,使得未来与大型人工智能服务的交互更人性化。

- 人工智能PC的普及将成为新计算平台的基础,PC将托管带有人工智能的应用程序。

- 生成式AI推动软件全栈重塑

- 生成式AI引领软件全栈的变革,推动各行各业的应用程序从指令编写转向智能生成。

15分钟浓缩视频,翻译宝玉

演讲文字版全文:https://mp.weixin.qq.com/s/83JwMgI-IJ0OEmIEJbwRrw

主要项目介绍

-

Nvidia 发布 Rubin:

Rubin芯片平台是英伟达下一代AI芯片平台,Rubin芯片将采用全新的架构设计,集成更多先进的计算单元和加速器,优化数据处理和传输效率,支持更高的计算密度和性能输出。

Rubin 将配备新一代 GPU、基于 Arm 的新 CPU—Vera,以及采用 NVLink 6、CX9 SuperNIC 和 X1600 的先进网络平台,并融合 InfiniBand/以太网交换机。该平台预计于 2026 年推出,并将使用 HBM4 高带宽内存产品。

黄仁勋强调,英伟达将通过“一年一次”的更新节奏,打破传统的摩尔定律。摩尔定律通常指的是集成电路上可容纳的晶体管数目约每两年增加一倍的趋势,而英伟达计划以更快的速度推出新产品,推动计算能力的飞跃发展。

主要特点

- 高性能计算:

- Rubin芯片将继续推动英伟达在高性能计算领域的领导地位,特别是在人工智能和深度学习方面。

- 它将配备更多的计算核心和更高的计算能力,以满足未来人工智能模型日益增长的需求。

- 节能效率:

- Rubin芯片在提升计算能力的同时,还将显著降低能耗。

- 通过优化芯片架构和制造工艺,Rubin芯片将实现更高的性能功耗比。

- 新一代AI支持:

- Rubin平台将专为下一代人工智能应用设计,Rubin芯片不仅适用于传统的计算任务,还将支持生成式AI、大语言模型(LLM)、物理模拟等复杂AI应用,推动各个行业的智能化升级。

- 它将具备更强的并行计算能力,能够加速深度学习、自然语言处理和计算机视觉等领域的创新。

- 扩展性和灵活性:

- Rubin芯片将具备高度的扩展性,能够适应不同规模和类型的计算任务。

- 通过模块化设计,用户可以根据需求灵活配置计算资源,实现最佳性能。

- 生态系统支持:

- Rubin平台将得到英伟达强大的软件生态系统支持,包括CUDA、TensorRT、cuDNN等核心技术。

- 英伟达将持续提供全面的开发工具和优化库,帮助开发者充分利用Rubin芯片的强大性能。

未来发展计划

- 逐年升级:

- Rubin平台将每年推出新版本,不断提升性能和功能,以适应快速发展的人工智能技术需求。

- 2027年将推出Rubin Ultra版本,进一步提升计算能力和节能效率。

- 全方位应用:

- Rubin芯片将广泛应用于各个领域,包括数据中心、高性能计算、智能制造、自动驾驶等。

- 通过与合作伙伴的紧密合作,英伟达将推动Rubin芯片在全球范围内的应用和普及。

- 长远愿景:

- 英伟达的长期目标是通过Rubin平台,推动人工智能技术的持续进步和产业升级。

- Rubin芯片将成为未来智能世界的核心计算平台,助力各行各业实现数字化转型和智能化升级。

Rubin芯片的发布标志着英伟达在人工智能芯片领域的又一次重大突破,将为全球科技产业

- 高性能计算:

-

Project Earth 2:

Project Earth 2 是英伟达在Computex 2024发布会上介绍的一个雄心勃勃的项目,Project Earth 2通过模拟整个地球的运行,帮助科学家和决策者更好地理解和应对气候变化及其影响。旨在创建地球的数字孪生体,以模拟和预测地球的未来变化。

- 项目目标:

- 数字孪生体:创建一个精确的地球数字孪生体,通过模拟地球的运行,帮助预测未来的变化。

- 气候变化预防:通过精确的模拟和预测,更好地预防气候变化带来的灾难。

- 深刻理解气候影响:通过这些模拟,更好地预防灾难,深入理解气候变化的影响,并采取相应的措施进行适应和改变。

- 技术方法:

- 基于CUDA的计算:项目利用英伟达的CUDA技术进行大规模并行计算,以提升计算效率。

- 生成式人工智能:采用生成式AI模型来理解和模拟物理现象,使AI能够生成物理世界的各种现象和数据。

- 强化学习:结合强化学习技术,通过自我对弈模式提升智能水平。

- 项目进展:

- 持续天气预报:未来将实现持续的天气预报,实现覆盖全球每一平方公里的持续天气预报。

- 人工智能训练:利用人工智能技术,训练模型以最低能耗持续进行气候预测。

- 精确模拟:通过高精度的物理模拟,生成可靠的预测数据。

.

- 项目目标:

-

cuDF ON:

加速一切!在任何行业中构建应用程序的速度提升 100 倍。

cuDF 是英伟达开发的一款 GPU 加速的 DataFrame 库,旨在提供类似于 Pandas 的功能,但利用 GPU 的并行计算能力显著加快数据处理速度。专为数据科学和分析任务设计。它是 Rapids.AI 项目的一部分,目标是利用 GPU 的并行处理能力提升数据处理的效率和性能。

QDF是NVIDIA推出的一款用于加速数据处理的工具库。它利用GPU的并行计算能力,显著提升了数据处理任务的速度。QDF可以与Pandas无缝集成,使得数据科学家可以在不改变代码的情况下,享受到GPU加速带来的性能提升。

在Google Colab上体验QDF加速Pandas

谷歌在其云端数据科学平台Colab上部署了QDF加速的Pandas。Colab是一个基于Jupyter Notebook的在线平台,用户可以在其中编写和执行Python代码,进行数据分析和机器学习任务。

通过在Colab上集成QDF,用户可以显著提升Pandas的数据处理速度,几乎瞬间完成原本耗时较长的任务。这种性能提升对于处理大规模数据集、进行复杂的数据分析任务尤为重要。

主要特点

- 高性能数据处理:

- 通过 GPU 加速,cuDF 能够显著提升数据处理速度,特别是在处理大规模数据集时。

- 它能够在数据预处理、数据清洗、特征工程等过程中提供显著的性能优势。

- Pandas 兼容 API:

- cuDF 提供与 Pandas 类似的 API,使得从 Pandas 迁移到 cuDF 变得非常简单。

- 用户可以利用熟悉的 Pandas 操作在 cuDF 中处理数据,无需重新学习新的接口。

- 大规模数据处理:

- cuDF 擅长处理超大规模数据集,能够在单台机器上处理超出内存容量的数据。

- 利用分布式计算,可以扩展到多台 GPU 和多节点环境中,处理更大规模的数据。

- 与其他 RAPIDS 库的无缝集成:

- cuDF 与 Rapids.AI 生态系统中的其他库(如 cuML、cuGraph)无缝集成,提供端到端的 GPU 加速数据科学工作流。

- 这种集成使得用户可以轻松地在数据处理、机器学习、图计算等任务之间切换,并保持高效的 GPU 加速。

应用场景

- 数据预处理和清洗:

- 数据科学和机器学习项目中,数据预处理和清洗是关键步骤。cuDF 通过 GPU 加速这些任务,显著提高效率。

- 特征工程:

- 在机器学习模型训练之前,特征工程是重要步骤。cuDF 提供快速的特征生成和转换能力,支持大规模特征工程任务。

- 实时数据分析:

- 对于需要实时处理和分析大规模数据的场景,如金融数据分析、物联网数据处理,cuDF 提供了快速、低延迟的数据处理能力。

- 分布式计算:

- 在分布式计算环境中,cuDF 可以与 Dask 等框架结合,提供跨多节点、多 GPU 的大规模数据处理能力。

- 高性能数据处理:

-

数字人类:

Avatar Cloud Engine(ACE)是英伟达开发的一项技术,旨在提供高质量、逼真的数字人(avatars)创建和管理服务。ACE 利用人工智能和图形技术,使得创建具有自然外观和行为的虚拟人类变得更加容易。

什么是 Avatar Cloud Engine(ACE)?

Avatar Cloud Engine(ACE)是一个云端平台,提供了创建和管理高质量数字人的工具和服务。它利用英伟达的图形处理单元(GPU)和人工智能技术,生成逼真的虚拟人类。这些数字人可以用于各种应用场景,如虚拟助手、娱乐、教育、客户服务等。

主要特点

- 高质量图形:

- ACE 利用英伟达的图形技术,生成高保真的数字人,包括逼真的面部表情、身体动作和皮肤纹理。

- 它能够处理复杂的光影效果,使得数字人的外观更加自然和真实。

- 人工智能驱动:

- 通过人工智能,ACE 能够实现自然的语音交互、情感表达和动作模拟。

- 它可以根据用户的输入生成相应的反应,使得互动更加生动和有趣。

- 云端计算:

- ACE 作为一个云端服务,能够利用强大的计算资源,支持大规模的数字人生成和管理。

- 用户无需购买昂贵的硬件设备,只需通过云端访问即可使用高性能的数字人生成服务。

- 实时交互:

- ACE 支持实时的数字人交互,使得数字人可以作为虚拟助手或客服代表,与用户进行即时沟通。

- 这种实时交互能力使得数字人在应用场景中更加实用和高效。

- 跨平台支持:

- ACE 提供了多种平台的支持,包括 PC、移动设备和 VR/AR 设备。

- 它可以无缝集成到现有的应用程序和服务中,提供一致的用户体验。

应用场景

- 虚拟助手:

- ACE 可以用于创建智能虚拟助手,提供个性化的服务和支持。

- 这些虚拟助手可以用于客户服务、在线购物、技术支持等领域。

- 娱乐和游戏:

- 在娱乐和游戏行业,ACE 可以用于创建栩栩如生的游戏角色和虚拟演员。

- 它还可以用于电影制作,生成逼真的特效角色。

- 教育和培训:

- ACE 可以用于虚拟教师和培训师的创建,提供交互式的教育体验。

- 它可以模拟复杂的场景和互动,提升学习效果。

- 医疗和护理:

- 在医疗和护理领域,ACE 可以用于创建虚拟护士和医生,提供远程医疗服务。

- 它可以模拟患者和医护人员之间的互动,进行医疗培训和模拟。

- 社交媒体和通信:

- ACE 可以用于创建个性化的虚拟形象,增强社交媒体和通信应用的互动性。

- 用户可以通过这些虚拟形象进行视频聊天、直播和其他互动活动。

未来电脑将像人类一样互动,在每个行业中:

- 广告

- 医疗

- 游戏

- 客户服务

- 高质量图形:

- NVIDIA Omniverse:使用 NVIDIA 库加速机器人应用开发。通过 Omniverse 乘风破浪迎接下一波 AI 创新。

- 自主运行的机器人:

- 黄仁勋强调,未来所有移动的物体都将实现自主运行。这意味着机器人将能够独立执行任务,无需人为干预。

- 这种自主运行不仅限于工业机器人,还包括各种服务机器人、无人驾驶汽车和无人机等。

- 机器人技术的发展:

- 英伟达的技术创新,如加速计算和大语言模型,将推动机器人技术的发展。

- 通过使用视频和合成数据进行学习,机器人将能够更好地理解和适应物理世界。

- AI之间的互相学习也将加速机器人智能的提升,使其在复杂环境中能够更高效地完成任务。

.

- 自主运行的机器人:

- NVIDIA Blackwell:最前沿的创新与无与伦比的性能相结合。Nvidia 的生产 Blackwell 板。它有 20000 TFLOPS 的 FP4。黄仁勋在演讲中展示了英伟达最新量产的Blackwell芯片。这款芯片代表了英伟达在芯片技术上的最新突破,是公司在计算硬件领域持续创新的重要成果。Blackwell Ultra AI芯片

黄仁勋宣布,英伟达计划在2025年推出Blackwell Ultra AI芯片。这款芯片是Blackwell系列的升级版,旨在进一步提升人工智能计算性能,为未来的AI应用提供更强大的支持。

-

Isaac ROS 3.0

Isaac ROS 3.0 是英伟达推出的机器人操作系统,旨在加速机器人应用的开发和部署。Isaac ROS 3.0 集成了英伟达的硬件加速和软件工具,提供了一套完整的开发环境,帮助开发者快速构建、测试和部署智能机器人。

主要特点

- 强大的计算平台

- Isaac ROS 3.0 利用英伟达的GPU加速计算能力,为机器人应用提供了强大的计算支持。通过GPU的并行处理能力,可以实现复杂的机器人算法和AI模型的实时运行。

- 优化的算法库

- Isaac ROS 3.0 提供了一系列优化的机器人算法库,包括视觉处理、路径规划、运动控制等。这些算法库经过优化,可以在英伟达的硬件平台上高效运行,显著提升机器人的性能和效率。

- 集成AI功能

- Isaac ROS 3.0 集成了深度学习和计算机视觉功能,支持机器人的感知、识别和决策能力。通过预训练的AI模型,机器人可以实现复杂的任务,如物体识别、环境感知、语音识别等。

- 支持多种传感器

- Isaac ROS 3.0 支持多种传感器的集成,包括摄像头、激光雷达、IMU(惯性测量单元)等。通过多传感器融合技术,机器人可以获得更全面的环境信息,提升自主导航和操作的能力。

- 易于开发和部署

- Isaac ROS 3.0 提供了丰富的开发工具和示例代码,帮助开发者快速上手。同时,支持Docker容器化部署,简化了机器人的开发和测试过程,加速了应用的迭代和发布。

- Isaac ROS 3.0 提供了丰富的开发工具和示例代码,帮助开发者快速上手。同时,支持Docker容器化部署,简化了机器人的开发和测试过程,加速了应用的迭代和发布。

主要功能

- 视觉处理

- 提供了基于深度学习的视觉处理模块,支持物体检测、分类、追踪等功能。通过GPU加速,视觉处理模块可以实时分析摄像头捕捉的图像,为机器人提供即时的视觉反馈。

- 路径规划

- 包含多种路径规划算法,如A*算法、Dijkstra算法等,帮助机器人在复杂环境中找到最优路径。支持动态避障和多机器人协作,提升机器人在实际应用中的导航能力。

- 运动控制

- 提供了精确的运动控制算法,支持机器人关节的精细控制和协调运动。通过模拟和实物测试,确保机器人的运动路径和操作精度。

- 环境感知

- 结合激光雷达和摄像头数据,构建机器人的三维环境地图。支持SLAM(同步定位与地图构建)技术,使机器人能够在未知环境中自主定位和导航。

应用场景

- 物流与仓储

- 在物流和仓储领域,Isaac ROS 3.0 可以用于自动搬运、货物分拣和仓库管理。通过精确的路径规划和运动控制,提高物流效率和准确性。

- 制造与装配

- 在制造业中,Isaac ROS 3.0 可以用于自动化生产线的监控和控制。机器人可以完成复杂的装配任务,提高生产效率和质量。

- 服务机器人

- Isaac ROS 3.0 还适用于服务机器人,如酒店机器人、送餐机器人等。通过环境感知和自主导航,服务机器人可以在公共场所灵活移动,提供多样化的服务。

- 农业与户外机器人

- 在农业和户外作业中,Isaac ROS 3.0 可以用于自动驾驶拖拉机、收割机等。通过多传感器融合技术,机器人可以在复杂的户外环境中自主作业,提高农业生产的智能化水平。相关链接:https://developer.nvidia.com/isaac

- 强大的计算平台

- NVIDIA NIM

NIM(NVIDIA Inference Microservices)是英伟达推出的一个集成化的人工智能容器解决方案,旨在简化AI模型的部署和管理。通过将复杂的AI计算堆栈封装在一个易于使用的容器中,NIM为用户提供了一个高效、灵活的人工智能服务平台。

主要特点

- 集成化容器

- NIM将AI所需的各种软件和库集成在一个容器中,包括CUDA、cuDNN、TensorRT、Triton推理服务等。用户只需下载和运行NIM容器,即可获得完整的AI服务支持。

- 云原生支持

- NIM支持Kubernetes等云原生环境,允许在分布式架构中自动扩展,方便用户在云端部署和管理AI服务。

- 预训练模型

- NIM提供了多种预训练的AI模型,涵盖语言、视觉、图像处理等多个领域。这些模型经过优化,可以直接用于生产环境,减少了用户的开发和训练成本。

- 标准API接口

- NIM容器提供标准化的API接口,用户可以通过这些接口与AI服务进行交互,简化了AI模型的集成和调用过程。

应用场景

- 客户服务代理

- NIM可以用于构建智能客户服务代理,利用预训练的语言模型和语义检索技术,提升客户服务的效率和质量。

- 行业定制

- 针对特定行业(如医疗保健、金融服务、制造业等),NIM提供了定制化的AI模型和服务,帮助企业解决特定问题。

- 数据处理与分析

- NIM支持大规模数据处理和分析任务,通过加速计算和优化的AI模型,显著提升数据处理的速度和效率。

- 集成化容器

- AI PC

英伟达宣布其 RTX 系列显卡将大力支持微软的全新 Copilot+ 计划,该计划旨在为 Windows 11 系统带来一系列强大的本地化功能。

首批适配的设备包括来自华硕的五款笔记本电脑以及来自微星的一款机型,由于 Copilot+ 目前尚未正式发布,这些笔记本电脑将预装常规版本的 Windows 11,但英伟达承诺,一旦 Copilot+ 上线,这些设备都将可以免费获得所有更新。

此前,Copilot + 功能仅限于高通骁龙硬件使用。此次引入 NVIDIA RTX 系列硬件让人期待其强劲的性能将如何影响这一领域。得益于强大的移动 GPU,RTX 系列可提供高达 1000 TOPS 的 AI 运算能力,远超骁龙 X 系列 Elite 版使用的专用 NPU 所提供的 45 TOPS。