Refuel AI 最近推出了两个新版本的大语言模型 RefuelLLM-2 和 RefuelLLM-2-small。

RefuelLLM-2 和 RefuelLLM-2-small 是专门为数据标注、清洗和丰富任务而设计的语言模型。

- 用途: RefuelLLM-2 主要用于自动化数据标注、数据清洗和数据丰富,这些任务是处理和分析大规模数据集时的基础工作,尤其是在需要将非结构化数据转换为结构化格式的场景中。

- 主要功能:

- 高性能数据标注: 该模型能自动识别和标记数据中的关键信息,如分类数据、解析特定属性等。

- 数据清洗: 自动识别和修正数据中的错误或不一致,如拼写错误、格式问题等。

- 数据丰富: 根据已有数据,自动补充缺失的信息或提供额外的上下文,增加数据的价值和可用性。

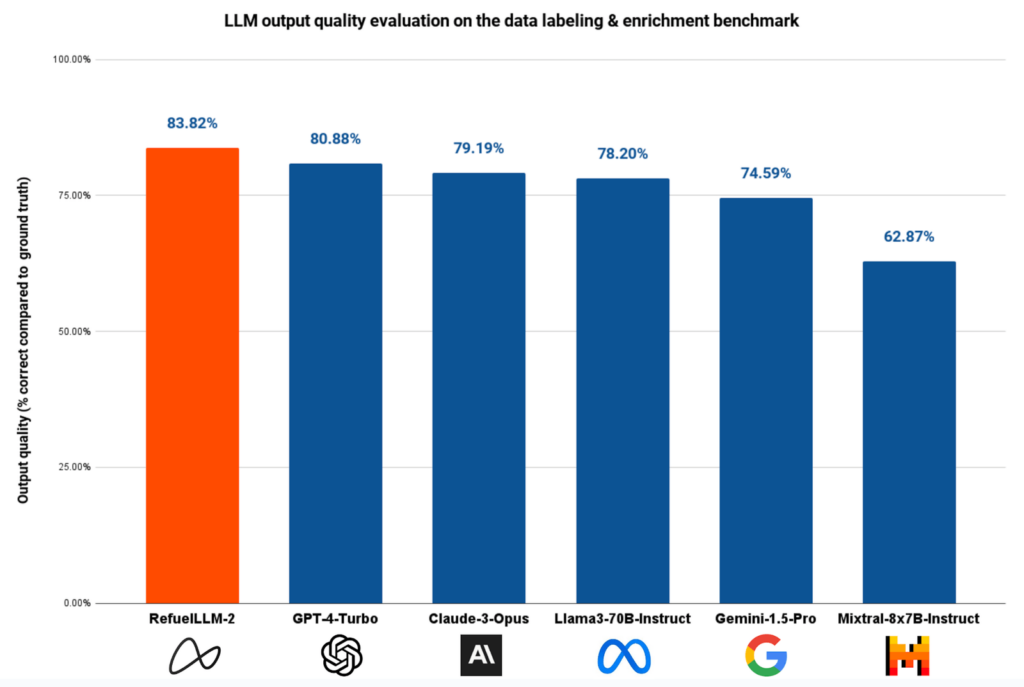

- 高准确率: 在约 30 项数据标注任务的基准测试中,RefuelLLM-2(83.82%)的表现优于所有最先进的LLMs ,包括 GPT-4-Turbo(80.88%)、Claude-3-Opus(79.19%)和 Gemini-1.5-Pro(74.59%)。

两款模型比较:

- 训练数据广泛: 两款模型都在涵盖多种任务的2750多个数据集上进行训练,这些数据集包括分类、阅读理解、结构化属性提取和实体解析等。

- 技术架构: RefuelLLM-2 基于 Mixtral-8x7B 模型,而 RefuelLLM-2-small 基于 Llama3-8B 模型,两者都能处理大规模的输入数据,尤其是 RefuelLLM-2 支持高达32K的最大输入上下文长度。

- RefuelLLM-2 在约30个数据标注任务中表现优于所有其他先进的大型语言模型,包括 GPT-4-Turbo 和 Claude-3-Opus。RefuelLLM-2的正确率为83.82%,而RefuelLLM-2-small(即Llama-3-Refueled)的正确率为79.67%,也超过了同类模型。

- RefuelLLM-2-small 是RefuelLLM-2 小型版本,设计目的是为了提供一个成本更低、运行更快,但依然保持较高性能的选择。虽然是小型版本,但依然能够处理复杂的数据标注任务,适合在资源受限的环境中使用。