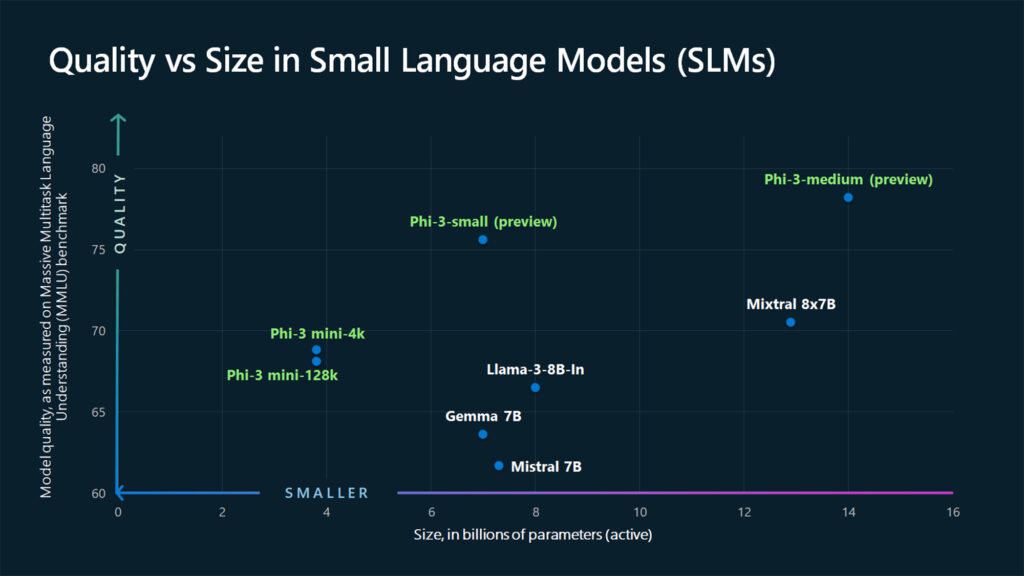

微软推出的Phi-3系列小型开源语言模型,在多种语言、推理、编程和数学基准测试中展示了前所未有的性能,超越了相同大小及更大型号的其他模型。

- Phi-3模型由于其小型化设计,在资源受限的设备上运行,同时能够保持高效性能。

- 适应多种环境: 适合部署在智能手机、嵌入式系统等边缘计算设备上,可以在不依赖云计算的情况下本地处理数据,减少延迟,增强隐私保护。

Phi-3- Medium 是 14B 参数,4.8T token 训练数据,MMLU 78%,MT-bench 8.9 分。

Phi-3系列主要特点:

-

多样化的型号选择:

- Phi-3系列包括Phi-3-mini(3.8亿参数)、Phi-3-small(70亿参数)和Phi-3-medium(140亿参数)等多种型号,覆盖不同性能和成本需求。

- 模型支持最长至128K令牌的上下文长度,Phi-3-mini是首款支持如此大上下文窗口的小型语言模型。

-

部署与兼容性:

- 模型可在Microsoft Azure AI Studio、Hugging Face和Ollama平台上使用。

- 支持ONNX Runtime优化,兼容Windows DirectML、跨平台的GPU、CPU以及移动硬件。

- 同时作为NVIDIA NIM微服务提供,支持标准API接口,可在任何地方部署。

-

Phi-3的优势:

- 适用于资源受限环境,如设备内和离线推理场景。

- 在延迟敏感场景中提供快速响应时间。

- 在成本受限的用例中,尤其是任务较简单的场景中,提供低成本选择。

Phi-3-mini

该模型具有3.8亿参数,经过3.3万亿tokens的训练,表现与Mixtral 8x7B和GPT-3.5等模型相当(例如,phi-3-mini在MMLU上获得了69%的得分,在MT-bench上获得了8.38的得分),其体积小到足以部署在手机上。

-

本地语言处理和生成:PhonePhi-3-mini 能在手机上本地运行,不需要连接到云端服务器,能即时处理和生成语言。这对于需要保护隐私或在无网络环境下工作的应用尤其有价值。