微软Azure宣布了一系列更新,旨在帮助开发人员利用Azure AI工具链快速创建定制的AI解决方案。包括Phi-3-mini和Phi-3-medium模型的无服务器微调,这些模型现在可以在云和边缘场景中快速、轻松地进行定制。更新还包括OpenAI、Meta和Mistral的最新模型,以提供更多选择和灵活性。

- Phi-3-mini 和 Phi-3-medium 模型的无服务器微调使开发者能够在无需安排计算资源的情况下快速轻松地定制这些模型,用于云和边缘场景。

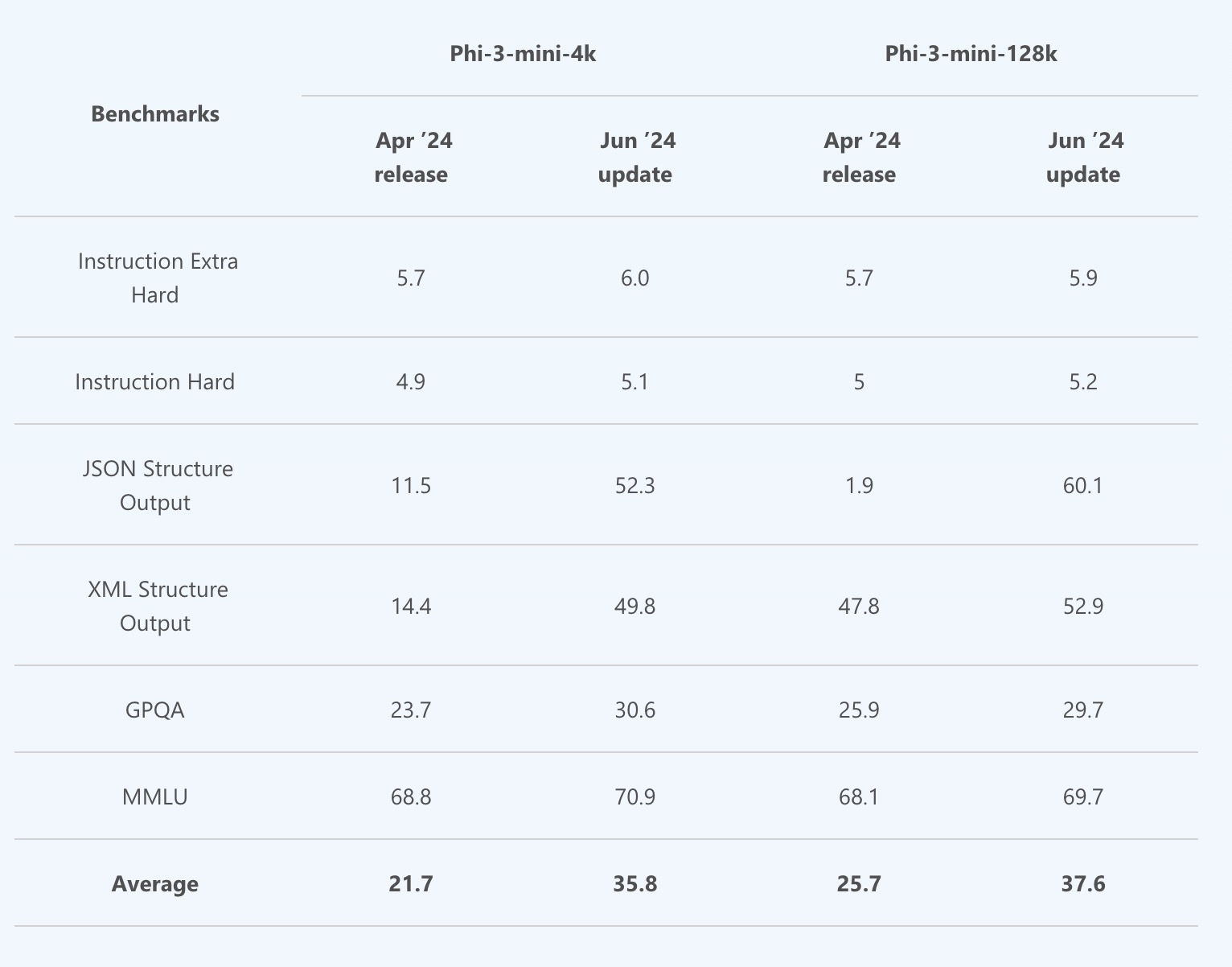

- Phi-3-mini 更新包括核心质量、指令跟随和结构化输出的显著提升,使开发者能够在无需额外成本的情况下构建性能更强的模型。

- 本月早些时候最新模型的同日发布包括 OpenAI (GPT-4o mini)、Meta (Llama 3.1 405B) 和 Mistral (Large 2) 到 Azure AI,提供了更大的选择和灵活性。

Phi-3家族的小型开放模型是微软最具成本效益的小型语言模型(SLM),并且已优化以改进指令跟随和结构化输出。Phi-3-mini和Phi-3-medium模型现在可以微调以构建更符合用户需求的AI体验。

Phi-3-mini更新内容包括以下几个方面:

- 核心质量改进:

- 提高了模型的核心质量,使其在各种应用场景中表现更好。

- 指令跟随能力:

- 重新训练模型,显著改进了指令跟随能力。现在模型更能准确理解和执行复杂的指令。

- 结构化输出支持:

- 增强了对JSON和XML格式结构化输出的支持,提升了输出的准确性和一致性。

- 多轮对话质量:

- 提高了多轮对话的质量,使得对话更流畅、更自然。

- 推理能力:

- 显著改进了模型的推理能力,使其在回答复杂问题时表现更好。

- 系统提示支持:

- 新增了对

<|system|>提示的支持,使模型能更好地理解和响应系统级指令。

- 新增了对

- 性能提升:

- 总体性能提升,包括在不同任务中的表现,例如数学问题的准确性和对错误的纠正能力。

- 指令跟随(Instruction Extra Hard):从5.7提升到6.0

- 结构化输出(JSON):从11.5提升到52.3

- 推理能力(GPQA):从23.7提升到30.6

Azure AI还引入了无服务器端点,方便开发人员快速入门AI开发。Phi-3-vision多模态模型也即将通过无服务器端点提供。

- 无服务器端点:无服务器端点(Serverless Endpoint)是一种云服务,开发者可以使用它来运行和管理AI模型,而不需要关心底层的服务器或硬件资源。这意味着开发者不需要配置、管理或维护物理或虚拟服务器,所有的基础设施管理都由云服务提供商(如Azure)负责。

- 快速轻松地开始AI开发:因为开发者不需要管理底层基础设施,他们可以专注于AI模型的开发和应用的实现。这加速了开发过程,使得开发者能够更快地部署和测试他们的AI应用程序。

- 简化管理:无服务器端点让开发者免去了处理服务器配置、负载均衡、扩展等复杂任务的麻烦。云服务会自动处理这些问题,确保应用的高可用性和可扩展性。

具体好处包括:

- 即用即付:开发者只需为实际使用的计算资源付费,而无需为闲置的资源买单。

- 自动扩展:云服务可以根据应用负载自动调整计算资源,确保应用在高峰期仍能正常运行。

- 减少运维工作:开发者不再需要进行服务器维护、软件更新和安全补丁管理等运维工作。

- 高效开发:开发者可以把更多时间和精力投入到模型优化和应用开发上,而不是基础设施管理。

Azure AI 现有超过 1600 种模型

Azure AI继续增加模型选择,目前已有超过1600个模型。微软致力于安全、负责任地构建AI解决方案,通过Azure AI评估和内容安全功能,帮助组织管理AI风险。

包括来自 AI21、Cohere、Databricks、Hugging Face、Meta、Mistral、Microsoft Research、OpenAI、Snowflake、Stability AI 等提供商的 1600 多种模型。本月我们增加了通过 Azure OpenAI 服务提供的 OpenAI 的 GPT-4o mini、Meta Llama 3.1 405B 和 Mistral Large 2。

Cohere Rerank 现已在 Azure 上提供。 Cohere 的企业级语言模型,结合 Azure AI 的强大基础设施,使企业能够无缝、可靠、安全地将最先进的语义搜索技术集成到他们的应用中。这一集成使用户能够利用 Azure 的灵活性和可扩展性,结合 Cohere 的高性能和高效语言模型,在生产中提供卓越的搜索结果。

Cohere 的旗舰生成模型 Command R+ 也在 Azure AI 上提供,专为与 Cohere Rerank 在检索增强生成 (RAG) 系统中配合工作而设计。它们一起能够在生产中满足一些最苛刻的企业工作负载需求。

本周早些时候,我们宣布 Meta Llama 3.1 405B 以及最新的微调 Llama 3.1 模型(包括 8B 和 70B)现已通过 Azure AI 的无服务器端点提供。Llama 3.1 405B 可用于高级合成数据生成和蒸馏,其中 405B-Instruct 作为教师模型,8B-Instruct/70B-Instruct 模型作为学生模型。了解更多关于此公告的信息。

Mistral Large 2 现已在 Azure 上提供,使 Azure 成为第一个提供这一下一代模型的领先云提供商。Mistral Large 2 在编码、推理和智能行为方面优于以前的版本,与其他领先模型不相上下。此外,Mistral Nemo 是与 NVIDIA 合作开发的,带来了一个强大的 12B 模型,推动了语言理解和生成的边界。了解更多。