Gemma 2 2B是Google推出的Gemma 2系列中一款重量级的轻量级AI模型,具有2亿参数。Gemma 2 2B 利用了知识蒸馏技术,通过从更大、更复杂的模型中学习,将其知识传递到较小的模型中,取得了超出预期的性能表现。

GEMMA 2 2B 模型适用于多种文本生成任务,包括问答、摘要和推理。其相对较小的体积使其能够在笔记本电脑、台式机或私人云基础设施等资源有限的环境中部署。

主要特点

1. 卓越性能

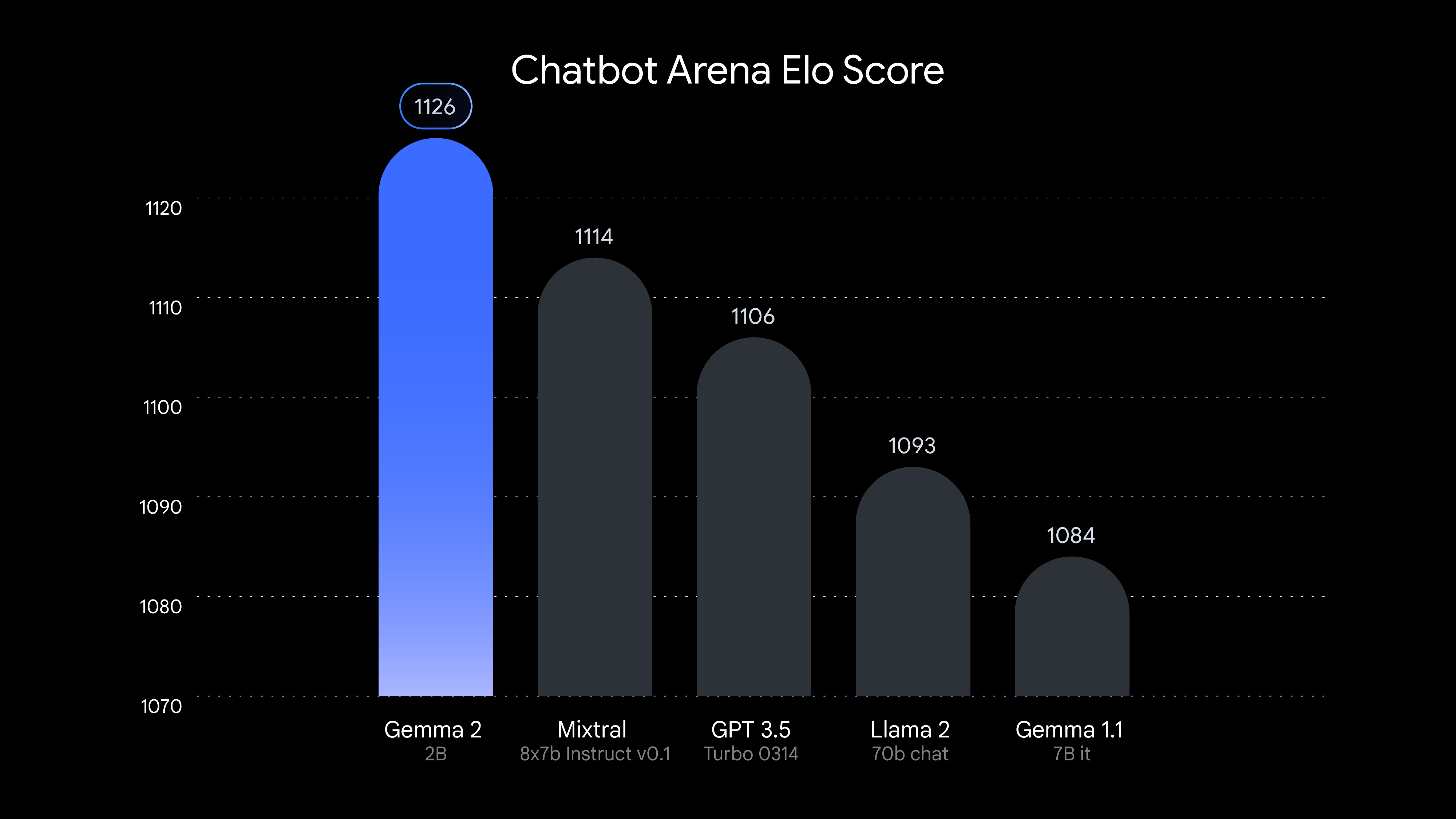

- 性能表现:Gemma 2 2B在LMSYS Chatbot Arena排行榜上超过了所有GPT-3.5模型,可以处理多种文本生成任务,如问答、摘要和推理,展示了其出色的对话AI能力。它在同类模型中表现最佳,能够在实际应用中提供高质量的对话体验。

- 优化:该模型经过优化,能够在各种硬件上高效运行。这包括各种边缘设备、笔记本电脑和强大的云部署,如Google的Vertex AI和Kubernetes Engine。

2. 灵活且具有成本效益的部署

2. 灵活且具有成本效益的部署

- 硬件兼容性:Gemma 2 2B可在从边缘设备到大型数据中心的广泛硬件上高效运行。它使用NVIDIA TensorRT-LLM库进行优化,支持NVIDIA RTX、GeForce RTX GPU和Jetson模块,适合各种AI应用场景。

- 经济高效:其设计允许在成本效益较高的硬件上运行,甚至可以在Google Colab的T4 GPU免费层上运行,使开发和实验更具经济效益。

3.模型集成与兼容性

Gemma 2 2B 设计为与多种主流 AI 开发平台无缝集成,方便开发人员在不同环境中使用:

- Keras 和 JAX:支持流行的深度学习框架,便于模型训练和推理。

- Hugging Face:兼容 Hugging Face 的模型和工具,简化模型管理和部署。

- NVIDIA NeMo 和 Ollama:利用这些平台的优化功能,进一步提升模型性能。

- MediaPipe(即将推出):支持实时处理任务,如视频和音频流处理。

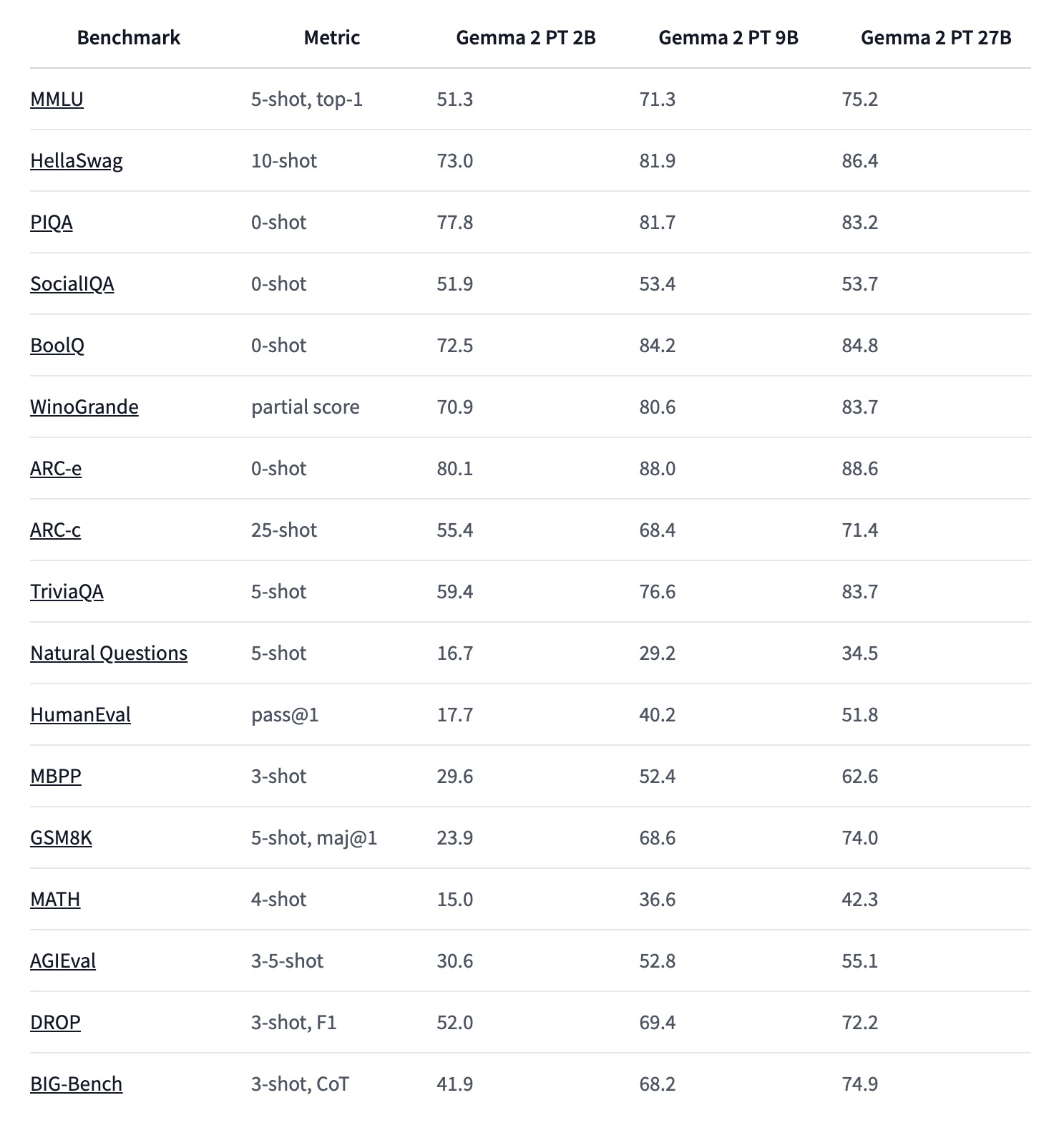

评估结果

GEMMA 2 2B 在多个基准测试中表现出色,尤其是在文本生成和问答任务中。以下是一些关键性能指标:

- MMLU (5-shot, top-1): 51.3

- HellaSwag (10-shot): 73.0

- PIQA (0-shot): 77.8

- BoolQ (0-shot): 72.5

- ARC-e (0-shot): 80.1

- TriviaQA (5-shot): 59.4

- GSM8K (5-shot, maj@1): 23.9