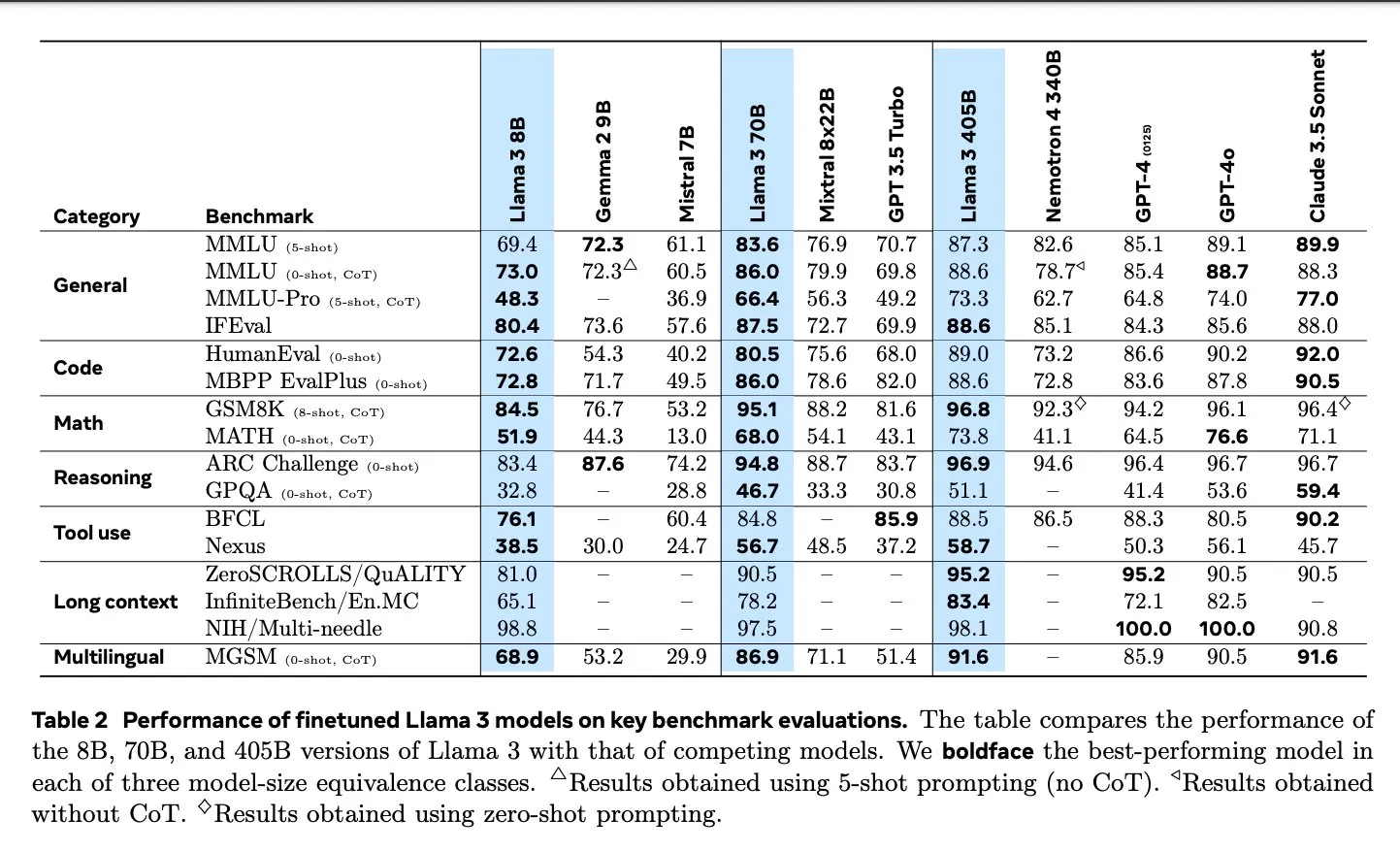

概要:Meta发布了有史以来最强大和最具能力的开源模型Llama 3-405B,该模型训练在15T令牌上,超过了GPT-4在所有主要基准测试中的表现。Llama 3的8B和70B型号也在4月的发布中进行了重大升级。

Latent Space采访了 Meta AI 研究员 Thomas Scialom,他领导了 Llama2 和现在的 Llama3 训练后工作。详细讨论了Llama 3.1预训练(如合成数据、数据管道、缩放法则等)和后训练(如强化学习人类反馈 (RLHF) 与指令调优、评估、工具调用)方面的内容。

- 合成数据:

- “我的直觉是,网络上的文本都是狗屎,在这些标记上进行训练是在浪费计算量”。

- “Llama 3 后期训练没有使用任何人类书写的答案,而是完全依赖于Llama 2生成的纯合成数据。”

- 合成数据的具体应用:

- 代码生成:使用三种方法生成代码合成数据,包括代码执行反馈、编程语言翻译和文档反向翻译。

- 数学推理:借鉴了“让我们逐步验证”作者的研究,进行合成数据生成。

- 多语言处理:通过90%的多语言令牌继续预训练,收集高质量的人类注释。

- 长文本处理:依赖于合成数据来处理长文本的问答、长文档摘要和代码库推理。

- 工具使用:在Brave搜索、Wolfram Alpha和Python解释器上训练进行单次、嵌套、并行和多轮函数调用。

- 强化学习与人类反馈(RLHF):

- 广泛使用人类偏好数据进行模型训练。

- 强调了人类在两者之间进行选择(如选择两首诗中更喜欢哪一首)而非创作(从零开始写一首诗)的能力。

- Meta 已经在 6 月份开始训练 Llama 4,听起来一大重点将是围绕智能体展开。

- 多模态版本将有更多参数,稍后发布

合成数据是关键

Llama3 在 15 万亿 tokens 上进行了训练,比 Llama2 多 7 倍,代码量增加了 4 倍,涵盖了 30 种不同的语言。正如 Thomas 所说: